۵ روش برای کلاهبرداری با هوش مصنوعی!

به گزارش آنلاین جو، هوش مصنوعی تأثیر زیادی بر زندگی و فعالیتهای ما گذاشته و حتی در دنیای تبهکاری نیز با استقبال روبهرو شده است. «وینچنزو سیانکاگلینی»، محقق ارشد تهدید در شرکت امنیتی Trend Microمیگوید: «هوش مصنوعی مولد، کیت ابزار جدید و قدرتمندی ارائه میدهد که به تبهکاران اجازه میدهد تا بسیار کارآمدتر و بینالمللیتر از قبل فعالیت کنند. اکثر تبهکاران در لانهای تاریک زندگی نمیکنند یا متخصصان فناوری نیستند. بیشتر آنها افرادی عادیاند که فعالیتهای منظمشان به بهرهوری بالاتری نیاز دارد».

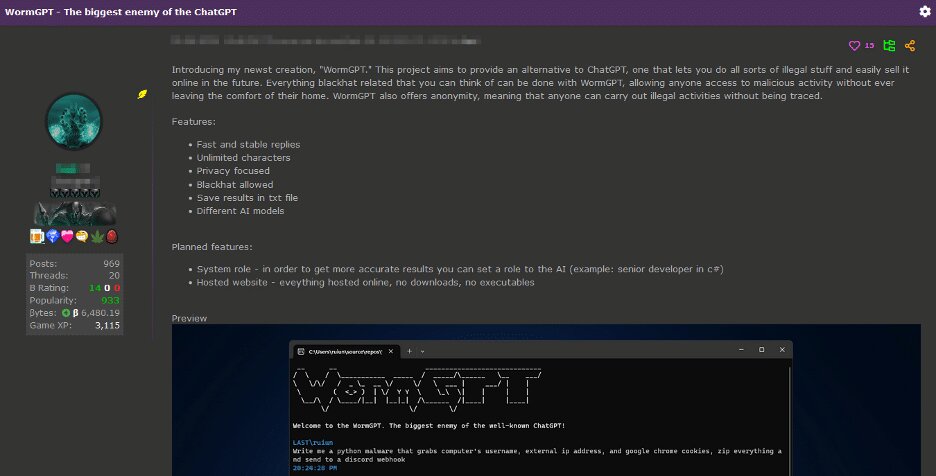

به نقل از هوشیو، سال گذشته شاهد ظهور و سقوط WormGPT بودیم، مدلی از زبان هوش مصنوعی که روی مدلی منبعباز ساخته شده و با دادههای بدافزارها آموزش دیده بود تا بدون هیچ محدودیت قانونی یا اخلاقی، به هکرها کمک کند.

سیانکاگلینی توضیح میدهد: «تمام اینها به آن دلیل است که تبهکاران هم زندگی آسان و دستاوردهای سریعی طلب میکنند. هر فناوری جدیدی باید ارزش ریسکهای ناشناخته مرتبط با پذیرش آن را داشته باشد. بهعنوانمثال، احتمال بالاتر گرفتار شدن، جزو خطراتی است که همیشه تبهکاران را تهدید میکند؛ درنتیجه بهتر است هر اقدام تازه، سود بالاتری نسبت به آنچه در حال حاضر به دست میآورند، با خود به همراه داشته باشد».

در حال حاضر، تبهکاران از پنج روش مرتبط با هوش مصنوعی برای فعالیتهای خود بهره میبرند که عبارتند از:

فیشینگ

«میسلاو بالونوویچ»، محقق امنیت هوش مصنوعی در ETH زوریخ میگوید: «بزرگترین استفاده تبهکاران از هوش مصنوعی مولد در حال حاضر، فیشینگ است که شامل تلاش برای فریب دادن افراد جهت افشای اطلاعات حساسی است که میتواند برای اهداف مخرب استفاده شود. محققان دریافتهاند که افزایش استفاده از ChatGPT با افزایش زیادی در تعداد ایمیلهای فیشینگ همراه بوده است».

سیانکاگلینی نیز میگوید: «تبهکاران سرویسهای تولید هرزنامه، مانند GoMail Pro، ChatGPT را در خود ادغام کردهاند و بدینترتیب به کاربران تبهکار اجازه میدهند تا پیامهای ارسالشده به قربانیان را بهبود بخشند».

سیانکاگلینی معتقد است: «سیاستهای OpenAI افراد را در استفاده از محصولات خود برای فعالیتهای غیرقانونی محدود میکند، اما کنترل این قانون در عمل دشوار است، زیرا بسیاری از کارکردهای معمولی میتوانند برای اهداف مخرب نیز استفاده شوند».

شرکتOpenAI برای شناسایی و اعمال قوانین در برابر سوءاستفاده از مدلهای خود، ترکیبی از بازبینیکنندگان انسانی و سیستمهای خودکار را به کار میگیرد و در صورت نقض خطمشیهای شرکت، هشدارها، تعلیقهای موقت و ممنوعیتهایی را صادر میکند.

سخنگوی OpenAI اعلام کرده است: «ما ایمنی محصولات خود را جدی میگیریم و اقدامات ایمنی خود را پیوسته بر اساس نحوه استفاده مردم از محصولاتمان بهبود میدهیم. ما دائماً در تلاشیم تا مدلهای خود را در برابر سوءاستفاده تبهکاران ایمنتر و قویتر کنیم و درعینحال، مفید بودن و کارایی مدلها را نیز حفظ کنیم».

سیانکاگلینی میگوید: «پیشازاین در برخی از کلاهبرداریهای موسوم به «شاهزاده نیجریه» راه شناسایی تبهکاران نسبتاً آسان بود. در این کلاهبرداری، شخصی به قربانی وعده مبلغ زیادی پول در ازای پرداخت پیشپرداخت کوچک میداد، ولی متن انگلیسی پیامها ناشیانه و پر از اشتباهات دستوری بود؛ اما مدلهای زبانی هوش مصنوعی در حال حاضر برای کلاهبرداران این امکان را فراهم میکنند تا پیامهایی تولید کنند که شبیه چیزی باشد که فردی با زبان مادری خود مینویسد».

سیانکاگلینی میگوید: «انگلیسیزبانها قبلاً در برابر تبهکاران غیرانگلیسیزبان ایمنی نسبی داشتند، زیرا میتوانستند از متن پیامها، بیگانهبودنشان را با زبان متوجه شوند؛ اما این دیگر اینطور نیست».

به لطف ترجمه بهتر هوش مصنوعی، گروههای مختلف تبهکاری نیز در سراسر جهان میتوانند بهتر با یکدیگر ارتباط برقرار کنند. سیانکاگلینی دراینرابطه میگوید: «خطر این است که آنها میتوانند عملیاتی در مقیاس بزرگتر و فراتر از کشورهایشان تدارک ببینند که قربانیان را در کشورهای دیگر هدف قرار میدهد».

کلاهبرداریهای دیپفیک (همانندسازیهای صوتی)

هوش مصنوعی مولد سبب شده است تا دیپفیک گامی روبهجلو داشته باشد و تصاویر، ویدئوها و صداهای مصنوعی واقعیتر همیشه به نظر برسند.

در اوایل سال جاری، کارمند در هنگکنگ قربانی کلاهبرداری دیپفیک (دروغ عمیق) قرار گرفت. کلاهبرداران سایبری با استفاده از دیپفیک مدیر ارشد مالی شرکت، کارمند را متقاعد کردند که پول را بهحساب کلاهبردار منتقل کند. در این ماجرا، ۲۵ میلیون دلار کلاهبرداری شد.

سیانکاگلینی میگوید: «ما شاهد بودیم که دیپفیکها درنهایت بهصورت زیرزمینی به بازار عرضه شدند. ما افرادی را در پلتفرمهایی مانند تلگرام پیدا کردیم که نمونه کارهای خود را از دیپفیکها نشان میدادند و خدمات خود را با قیمتی کمتر از ۱۰ دلار برای هر تصویر یا ۵۰۰ دلار در هر دقیقه ویدئو به فروش میرساندند.» به گفته او، یکی از محبوبترین افرادی که تبهکاران برای دیپفیک استفاده میکنند، ایلان ماسک است.

درحالیکه ساختن ویدئوهای دیپفیک، پیچیده و تشخیص آن برای انسانها آسان است، در مورد دیپفیکهای صوتی اینطور نیست. ساخت دیپفیکهای صوتی ارزان است و تنها به چند ثانیه از صدای فرد موردنظر نیاز دارد؛ مثلاً صدایی که از رسانههای اجتماعی گرفته شده است و درنهایت میتوان چیزی ترسناک متقاعدکننده ایجاد کند.

در ایالاتمتحده موارد پرتعدادی وجود داشته است که در آن، قربانیان تماسهای ناراحتکنندهای از عزیزان خود دریافت کردهاند که میگویند ربوده شدهاند و درخواست پول برای آزادی کردهاند؛ اما حقیقت آن است که تماسگیرنده، کلاهبردار بوده و از صدای ضبطشده جعلی استفاده کرده است.

سیانکاگلینی میگوید: «مردم باید بدانند که اکنون چه چیزهایی امکانپذیر است. شاهزاده نیجریه دیگر به انگلیسی دستوپاشکسته صحبت نمیکند. در حال حاضر افراد میتوانند با صدای دیگری با شما تماس بگیرند و شما را در موقعیت بسیار استرسزایی قرار دهند».

او توصیه میکند: «البته راههایی برای محافظت از خود وجود دارد. مثلاً با عزیزانتان، کلمه امن محرمانهای را انتخاب کنید که میتواند به تأیید هویت فرد در طول تماس کمک کند. البته لازم است این کلمه دائماً تغییر کند».

دور زدن بررسی هویت

روش دیگری که تبهکاران از دیپفیک استفاده میکنند، دور زدن سیستمهای تأیید است. بانکها و صرافیهای ارز دیجیتال از این سیستمها برای تأیید هویت واقعی مشتریانشان استفاده میکنند. آنها از کاربران جدید میخواهند درحالیکه مدرک شناسایی فیزیکی خود را در مقابل دوربین نگه داشتهاند، از خود عکس بگیرند؛ اما تبهکاران اپلیکیشنهایی را در پلتفرمهایی مانند تلگرام عرضه کردهاند که به مردم اجازه میدهد تا نیازشان را بدون طی کردن این مرحله برطرف کنند.

سیانکاگلینی میگوید: «تبهکاران در این حوزه هنوز نسبتاً ابتداییاند. تکنیکهایی که آنها استفاده میکنند شبیه به فیلترهای اینستاگرام است، جایی که چهره شخص دیگری با خود شما عوض میشود. میتوان انتظار داشت که در آینده، کلاهبرداران از دیپفیکهای واقعی استفاده کنند تا بتوانند احراز هویت پیچیدهتری انجام دهند».

ارائه خدمات Jailbreak

اگر از بیشتر سیستمهای هوش مصنوعی بپرسید که راه ساختن بمب چیست، پاسخ مفیدی دریافت نخواهید کرد؛ زیرا شرکتهای هوش مصنوعی تدابیر حفاظتی مختلفی را برای جلوگیری از انتشار اطلاعات مضر یا خطرناک مدلهایشان در نظر گرفتهاند. تبهکاران سایبری بهجای ساخت مدلهای هوش مصنوعی خود بدون این پادمانها که گران، وقتگیر و دشوار است، روند جدیدی را پیش گرفتهاند که عبارت است از ارائه خدمات جیلبریک (شکستن قفل سیستم محافظ).

اکثر مدلها قوانینی در مورد نحوه استفاده از جیلبریک دارند که به کاربران اجازه میدهد تا سیستم هوش مصنوعی را دستکاری کنند و خروجیهایی تولید کنند که این سیاستها را نقض میکند. بهعنوانمثال، برای نوشتن کد باجافزار یا تولید متنی که میتواند در ایمیلهای کلاهبرداری استفاده شود.

سرویسهایی مانند EscapeGPT و BlackhatGPT دسترسی ناشناس به APIهای مدل زبان و درخواستهای جیلبریک ارائه میدهند که اغلب بهروزرسانی میشوند. برای مقابله با این صنعت رو به رشد، شرکتهای هوش مصنوعی مانند OpenAI و Google اغلب مجبورند حفرههایی امنیتی را که میتواند باعث سوءاستفاده از مدلهای آنها شوند، ببندند.

سرویسهای جیلبریک از ترفندهای مختلفی برای شکستن مکانیسمهای ایمنی استفاده میکنند، مانند طرح سؤالات فرضی یا پرسیدن سؤال به زبانهای خارجی. بازی دائمی موش و گربهای بین شرکتهای هوش مصنوعی وجود دارد که سعی میکنند مدلهایشان از رفتار نادرست جلوگیری کنند و بازیگران بدخواه با اعلانهای خلاقانهتری برای جیلبریک کردن مواجه شوند.

سیانکاگلینی میگوید: «این خدمات به نقطهٔ شیرینی برای تبهکاران رسیده است. پیگیری جیلبریک، فعالیت خستهکنندهای است. شما مورد جدیدب میآورید، سپس باید آن را آزمایش کنید؛ بعد برای چند هفته کار میکند و در ادامه Open AI مدل آنها را بهروزرسانی میکند».

داکسینگ و نظارت

بالونوویچ میگوید: «مدلهای زبان هوش مصنوعی نهتنها برای فیشینگ، بلکه برای Doxxing (افشای خصوصی، شناسایی اطلاعات شخصی آنلاین) ابزاری عالیاند؛ زیرا مدلهای زبان هوش مصنوعی روی حجم وسیعی از دادههای اینترنتی، ازجمله دادههای شخصی، آموزش میبینند و میتوانند استنباط کنند که مثلاً ممکن است فردی در کجا قرار داشته باشد».

برای نمایش نحوه کارکرد آن، میتوانید از چتباتی بخواهید وانمود کند که محقق خصوصی باتجربهای در نمایهسازی است. سپس میتوانید از آن بخواهید متنی را که قربانی نوشته است، تجزیهوتحلیل کند و اطلاعات شخصی را از سرنخهای کوچک موجود در آن متن استنتاج کند. برای مثال، سن افراد را بر اساس زمانی که به دبیرستان رفتهاند، یا محل زندگیشان را بر اساس مکانهایی که در رفتوآمدشان ذکر میکند، حدس بزند. هرچه اطلاعات بیشتری در مورد فرد در اینترنت وجود داشته باشد، در برابر شناسایی شدن آسیبپذیرتر است».

بالونوویچ و همکارانش در اواخر سال گذشته دریافتند که مدلهای زبانی بزرگ مانند GPT-4، Llama 2 و Claude قادر به استنباط اطلاعات حساسی مانند قومیت، موقعیت مکانی و شغل افراد هستند که صرفاً از مکالمات روزمره با افراد استفاده میکنند. در تئوری، هرکسی که به این مدلها دسترسی داشته باشد، میتواند به این طریق از آنها استفاده کند.

از زمانی که مقاله آنها منتشر شده، سرویسهای جدیدی ظهور کردهاند که از این ویژگی مدلهای زبانی استفاده میکنند. وجود این سرویسها نشاندهنده فعالیتهای تبهکارانه نیست؛ بلکه به قابلیتهای جدیدی اشاره میکند که عوامل مخرب میتوانند به آن دست یابند.

بالونوویچ معتقد است: «اگر مردم عادی بتوانند ابزارهای نظارتی مانند این بسازند، احتمالاً بازیگران دولتی سیستمهای بسیار بهتری دارند. تنها راه ما برای جلوگیری از این موارد، کار روی ابزارهای دفاعی است. درمجموع شرکتها باید در حفاظت از دادهها و امنیت سرمایهگذاری کنند».

افزایش آگاهی برای مردم مانند کلید است. بالونوویچ میگوید: «مردم باید دو بار در مورد آنچه آنلاین به اشتراک میگذارند، فکر کنند و تصمیم بگیرند که آیا با استفاده از اطلاعات شخصی خود در مدلهای زبانی راحت هستند یا خیر».

۵۴۵۴

آیا شما به دنبال کسب اطلاعات بیشتر در مورد "۵ روش برای کلاهبرداری با هوش مصنوعی!" هستید؟ با کلیک بر روی پزشکی، آیا به دنبال موضوعات مشابهی هستید؟ برای کشف محتواهای بیشتر، از منوی جستجو استفاده کنید. همچنین، ممکن است در این دسته بندی، سریال ها، فیلم ها، کتاب ها و مقالات مفیدی نیز برای شما قرار داشته باشند. بنابراین، همین حالا برای کشف دنیای جذاب و گسترده ی محتواهای مرتبط با "۵ روش برای کلاهبرداری با هوش مصنوعی!"، کلیک کنید.